LangGraph 为大家提供了方便的调试界面,这个功能由 LangGraph CLI 提供。

⚠️ 请注意,这个功能不是端侧的。也就是说,使用该功能必须联网,且你的信息会发送到 LangChain 团队的服务器。因此请务必不要在该页面访问敏感数据!

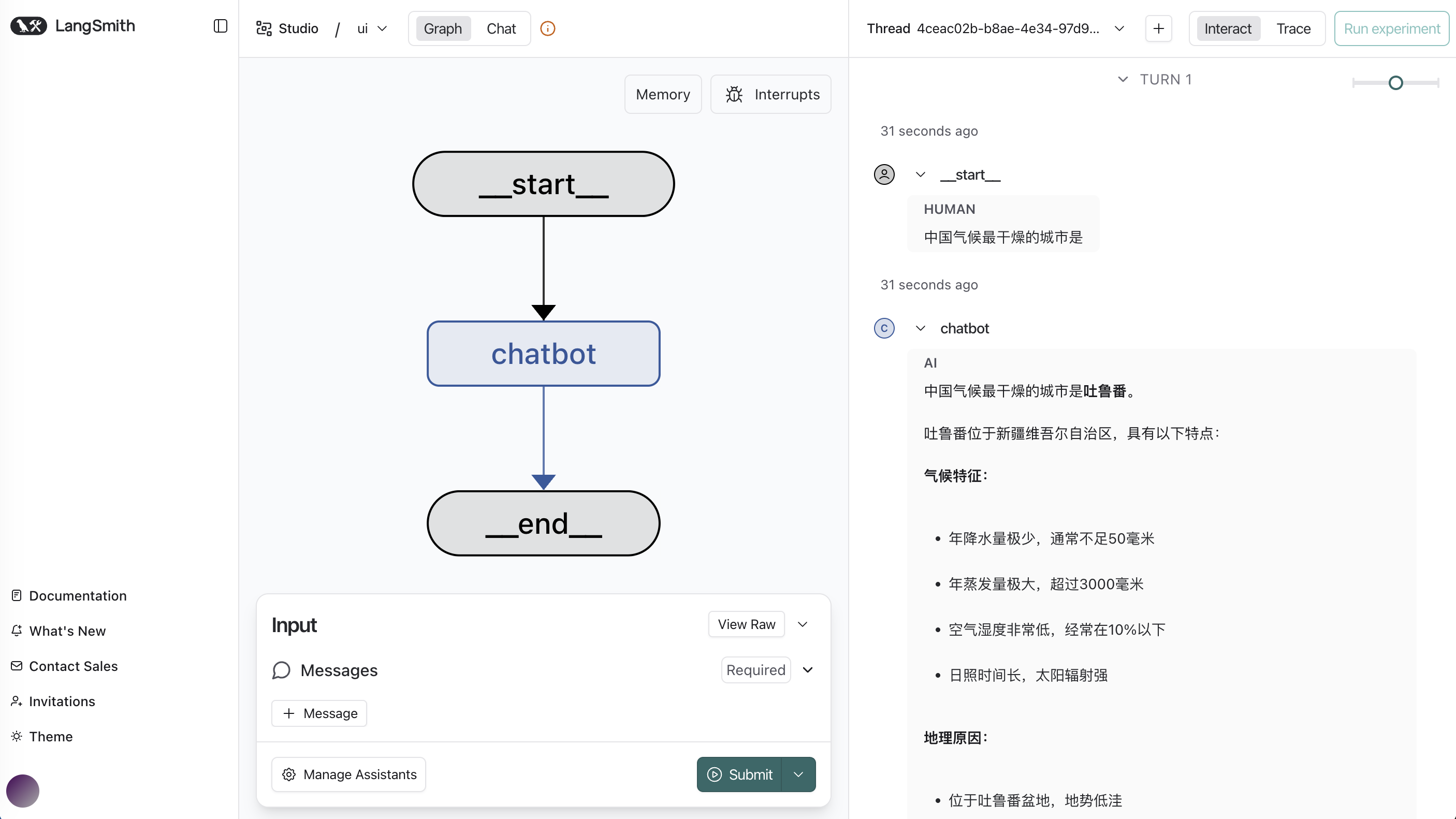

调试界面由 LangSmith 提供,页面如下:

一、langsmith¶

LangSmith 是由 LangChain 团队推出的 LLM 应用的数据分析平台,它能帮助开发者可视化地管理和优化整个应用开发流程。LangSmith 是一个付费 PaaS,但提供部分免费功能。

二、langgraph-cli¶

1)安装依赖¶

使用服务前,先安装依赖:

pip install "langgraph-cli[inmem]"2)开发 Agent 后端¶

这里,我们开发一个简单的 Agent 作为该调试界面的后端。代码如下:

import os

from dotenv import load_dotenv

from langchain_openai import ChatOpenAI

from langchain.agents import create_agent

# 加载模型配置

_ = load_dotenv()

# 配置大模型服务

llm = ChatOpenAI(

api_key=os.getenv("DASHSCOPE_API_KEY"),

base_url=os.getenv("DASHSCOPE_BASE_URL"),

model="qwen3-coder-plus",

)

# 创建Agent

agent = create_agent(model=llm)

# langgraph-cli 入口函数

def get_app():

return agent

Source: simple_agent.py

3)编写配置文件¶

langgraph-cli 默认的配置文件叫 langgraph.json.

若使用其他文件名,在启动服务时,需要使用

--config参数指定你的 json 文件名。

{

"dependencies": [

"./"

],

"graphs": {

"supervisor": "./simple_agent.py:get_app"

},

"env": "./.env"

}4)启动 langgraph-cli¶

在命令行启动服务:

# 如果你的配置文件是默认的 langgraph.json

langgraph dev

# 如果你的配置文件是 [your_agent].json

langgraph dev --config [your_agent].json运行后会自动跳转到浏览器的调试页面。

由于这个 Chat 页面不是开源的,不建议将其用于生产环境。如果你需要一个替代的开源前端 Chat 页面,可参考我的 clickhouse-chatbi 项目。该项目使用了 Next.js 的 nextjs-ai-chatbot 模板。该模板兼具现代的外观和易用的功能,实乃快捷开发的不二之选。